AIが私たちの仕事や生活にどんどん浸透してきていますね。特に最近注目されているのが、「RAG(検索拡張生成)」という技術です。社内FAQシステムやドキュメント検索など、検索機能を要する仕組みに活用が進んでいるそうですよ。私もAIを活用する中で、「もっと賢く、もっと正確に情報を得たい!」と感じていたので、このRAGについて深掘りしてみることにしました。

RAGって、そもそも何?

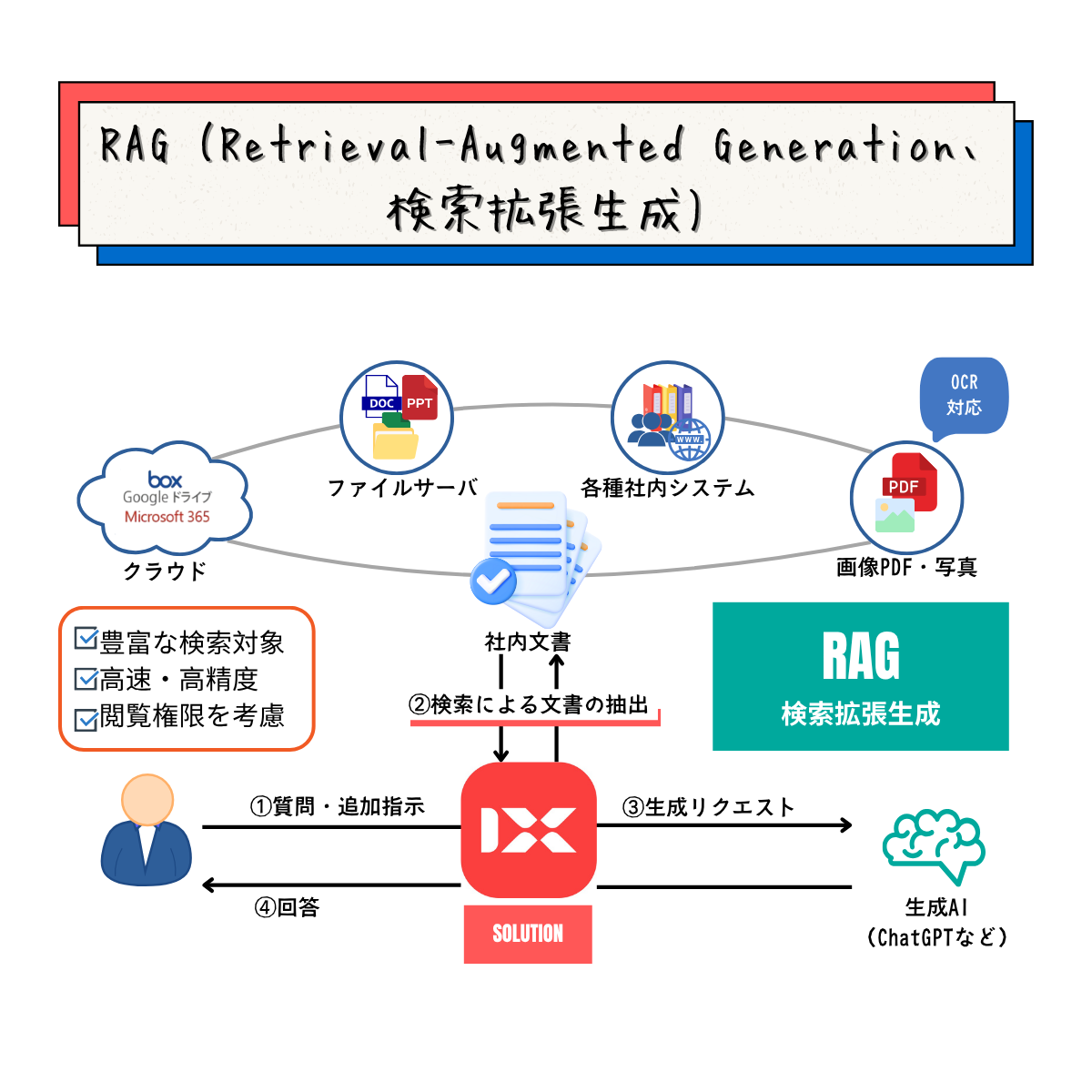

RAGは「Retrieval-Augmented Generation」の略称で、まさに「検索拡張生成」という名前の通り、検索(Retrieval)機能を拡張(Augmented)し、質の高い回答を生成(Generation)する技術なんです。

簡単に言うと、AI(人工知能)を使ってデータ検索結果の精度を高め、その結果を人間が理解しやすい自然な文章で生成してくれる技術ですね。

このRAGは、大規模言語モデル(LLM)というAIと組み合わせて使われています。

ちょっと待って、LLMって何だっけ?

LLM(Large Language Models)は、膨大なデータを学習してトレーニングされたAIの一種で、多様な自然言語処理(NLP)を実行できます。私たちが普段話したり書いたりする「自然言語」をAIが解析・分析し、文脈を考慮してコンピュータで扱えるようにしてくれます。

だから、RAGでは使い慣れた言葉で検索や指示出しができるし、検索結果も自然な文章で返ってくるので、とても使いやすいんです。

なぜ今、RAGがこんなに注目されているの?

RAGが注目される最大の理由は、AIが事実ではないことをあたかも事実であるかのように出力してしまう「ハルシネーション(幻覚)」という問題を防ぐのに有効だからです。

RAGは、信頼できるデータベースやソースを検索して回答を生成する仕組みなので、このハルシネーションを回避できるとされています。

さらに、RAGは非公開情報や最新情報も検索対象に含めることができるという点でも優れています。これはビジネスで使う上で大きな強みですね。

RAGって、どういう仕組みで動いているの?

チャットAIアプリを例に、RAGの流れを見てみましょう。

- ユーザーがチャットAIアプリに入力する

質問や指示を入力します。 - AIがデータベースを検索する

社内ナレッジベースやWebを検索します。 - 検索結果データを取得

ベクトル検索やハイブリッド検索で関連情報を取得。 - LLMに質問する

取得したデータをもとに、LLMへ投げかけます。 - LLMが回答を生成する

自然言語でわかりやすい回答を生成します。 - ユーザーへ出力

自然な文章で結果が返ってきます。

RAGを導入するメリットって何?

- ハルシネーションの回避、回答精度の向上

- 「わかりません」と回答させられる

- 最新情報を取得できる

- 少ない学習データでも高精度なタスク実行が可能

RAGはどんなところで活用されているの?

- 社内FAQシステム

- 社内ドキュメント検索

- 営業・マーケティング分野のリード特定

- 顧客サポートの精度向上

RAGの精度をもっと高めるには?

- 高品質なリトリーバルデータの準備

- 効果的なリトリーバルモデルの選択とチューニング

- 生成モデルの最適化(GPT, BERTなど)

- エンドツーエンドのトレーニング

- フィードバックループの導入

- 多様なデータセットの使用

- ハイパーパラメータの調整

まとめ

RAG(検索拡張生成)は、社内のナレッジやデータを効率的に検索し、必要な情報を自然な言葉で得られる画期的な技術です。

ハルシネーションを防ぎ、最新情報を利用できる点は、これからのAI活用において非常に重要です。業務の効率化や顧客対応の精度向上など、様々な分野で活躍が期待されます。

うまく活用すれば、私たちの仕事がもっとスムーズになること間違いなし!ぜひ、みなさんもこのRAGに注目してみてくださいね。